Capítulo 11. Análise da qualidade metodológica de estudos observacionais (coorte, caso-controle e transversal) com as ferramentas do Joanna Briggs Institute (JBI)

CAPÍTULO 11

Análise da Qualidade Metodológica de Estudos Observacionais (Coorte, Caso-Controle e Transversal) com as Ferramentas do Joanna Briggs Institute (JBI)

Jéssica Conti Réus, Lia Rosana Honnef, Carla Massignan, Cristine Miron Stefani, Graziela De Luca Canto

1. Introdução

As ferramentas de avaliação crítica do Joanna Briggs Institute (JBI) foram desenvolvidas por colaboradores e aprovadas pelo Comitê Científico da JBI após extensa revisão por pares. Essas ferramentas têm a finalidade de avaliar a qualidade metodológica de cada estudo incluído nas Revisões Sistemáticas (RS) e determinar até que ponto um estudo abordou a possibilidade de viés em seu desenho, condução e análise.1

Essa avaliação é feita baseada em uma série de perguntas, as quais estão agrupadas de acordo com o desenho dos estudos incluídos na RS. O JBI tem ferramentas para a avaliação de: texto e opinião, pesquisa qualitativa, relato de caso, série de casos, prevalência, transversal analítico, caso-controle, coorte, avaliação econômica, acurácia de testes diagnósticos, quasi-experimentais (before-and-after), ensaios clínicos randomizados e Revisões Sistemáticas.

O Quadro 1 elenca os checklists JBI com a respectiva indicação para uso nos diferentes tipos de RS, disponíveis gratuitamente no website da JBI (https://jbi.global/critical-appraisal-tools).

Quadro 1. Checklists do Joanna Briggs Institute e respectivas indicações para os diferentes tipos de Revisão Sistemática

| Checklists JBI Disponíveis | Indicação (tipos de RS) |

| Checklist para pesquisa qualitativa

Checklist para texto e opinião Checklist para relato de caso Checklist para série de casos Checklist para estudo transversal analítico Checklist para estudos de prevalência Checklist para estudo caso-controle Checklist para estudo de coorte Checklist para estudo de avaliação econômica Checklist para estudo de acurácia de testes diagnósticos Checklist para estudos quasi-experimentais Checklist para Ensaios Clínicos Randomizados Checklist para Revisões Sistemáticas |

RS Qualitativa / RS de Métodos Mistos

RS Descritiva / RS Fenomenológica RS Descritiva / RS Fenomenológica RS Descritiva / RS Fenomenológica RS de Associação RS de Prevalência RS de Associação RS de Fator de Risco RS de Custo-Efetividade RS de Acurácia de Testes Diagnósticos

RS de Intervenção (Efetividade) RS de Intervenção (Efetividade) Overviews (Revisões de Revisões) |

Fonte: elaborado pelos autores.

Este capítulo abordará, unicamente, as ferramentas de análise crítica do JBI para estudos observacionais de coorte, caso-controle e transversal. Uma orientação específica para o checklist de prevalência é abordada separadamente no Capítulo 12 deste livro.

2. Aplicação

A aplicação das ferramentas de qualidade metodológica do JBI segue as orientações contidas no Capítulo 1.

Os estudos incluídos devem ser agrupados de acordo com o seu desenho, sendo que, para cada grupo, deve ser utilizada uma ferramenta. Por exemplo, se de dez artigos incluídos, cinco forem caso-controle e cinco transversais analíticos, devem ser usadas duas ferramentas diferentes. Essa regra não se aplica para as RS de prevalência, nas quais se usa o checklist de prevalência, independentemente dos desenhos dos estudos incluídos, como explicado no Capítulo 12.

A seguir, serão apresentadas as ferramentas do JBI para estudos de coorte, caso-controle e transversais analíticos. Para todas as ferramentas, há quatro possibilidades de respostas para cada pergunta: “Sim”, “Não”, “Incerto” e “Não aplicável”. Se o estudo primário atendeu a todos os critérios descritos, recebe resposta “Sim” na pergunta em questão. Se o estudo não desenvolveu/avaliou da forma que está descrita na pergunta ou não mencionou o item em questão, recebe a resposta “Não”. Para qualquer item, se não ficou claro como aquele tópico foi desenvolvido, recebe a resposta “Incerto”. Por fim, se o questionamento não se aplica para o que se está sendo analisado, a resposta é “Não se aplica”.

2.1. Análise da qualidade metodológica em estudos de coorte1

A ferramenta é composta por 11 perguntas, as quais serão apresentadas a seguir, em tradução livre para a língua portuguesa, com orientações para análise. Ao final, é apresentado um quadro com as perguntas originais em inglês (Quadro 2).

- Os dois grupos eram semelhantes e recrutados na mesma população?

Critérios para receber resposta “Sim”: se os participantes intra e intergrupos forem o mais semelhante possível em todas as características relevantes para o estudo em questão, exceto quanto ao status de exposição. Os avaliadores devem verificar se os autores do estudo original informaram claramente os critérios de inclusão e exclusão estabelecidos previamente ao recrutamento dos participantes do estudo.

- As exposições foram medidas de forma semelhante para atribuir participantes aos grupos expostos e não expostos?

Critérios para receber resposta “Sim”: se as medidas de exposição foram claramente definidas e descritas em detalhes, permitindo aos avaliadores identificar se os participantes apresentavam ou não a exposição de interesse.

- A exposição foi medida de forma válida e confiável?

Critérios para receber resposta “Sim”: se o estudo descreveu claramente como a exposição foi medida. A validade da verificação da exposição está relacionada à adequação dos instrumentos ou métodos utilizados, se foram desenvolvidos para o estudo em avaliação ou se haveria outras formas validadas descritas na literatura (existência de um padrão de referência, por exemplo). Já a confiabilidade, refere-se à descrição dos métodos adotados para assegurar a reprodutibilidade da medida da exposição (confiabilidade intra e interobservador).

- Foram identificados fatores de confusão?

Critérios para receber resposta “Sim”: se os autores do estudo identificaram e mensuraram os fatores de confusão em potencial. Há fatores de confusão quando o efeito estimado da amostra, após a exposição, é enviesado pela presença de alguma diferença entre os grupos de comparação (além da exposição investigada/de interesse). Os fatores de confusão típicos incluem características iniciais (no baseline), fatores prognósticos ou exposições concomitantes (por exemplo, tabagismo).

- Foram estabelecidas estratégias para lidar com os fatores de confusão?

Critérios para receber resposta “Sim”: se os efeitos dos fatores de confusão foram ajustados por meio de análise estatística ou estratificação da amostragem dos participantes. O método estatístico utilizado para explicação dos fatores de confusão, geralmente, envolve alguma forma de análise de regressão multivariada.

- Os grupos/participantes eram livres do desfecho no início do estudo (ou no momento da exposição)?

Critérios para receber resposta “Sim”: se o estudo mencionou que os participantes não apresentavam os desfechos de interesse no início do estudo. A seção “Métodos” no estudo em análise deve ser consultada para obter essas informações, que, geralmente, são encontradas nas descrições de recrutamento de participantes/amostra, definições de variáveis e/ou critérios de elegibilidade.

- Os resultados foram medidos de forma válida e confiável?

Critérios para receber resposta “Sim”: se o estudo descreveu claramente como o desfecho foi medido. Esta pergunta é semelhante à 3, porém, com enfoque em como os desfechos foram medidos/diagnosticados. A validade da verificação do desfecho está relacionada à adequação dos instrumentos ou métodos utilizados, se foram desenvolvidos para o estudo ou se haveria outras formas validadas descritas na literatura (existência de um padrão de referência, por exemplo). Já a confiabilidade, refere-se à descrição de métodos adotados para assegurar reprodutibilidade da medida do desfecho (confiabilidade intra e interobservador).

- O tempo de acompanhamento foi relatado e longo o suficiente para que os desfechos ocorressem?

Critérios para receber resposta “Sim”: se o tempo de acompanhamento foi longo o suficiente para o desfecho ocorrer. Cabe ressaltar que a questão da pesquisa e os desfechos examinados definem o tempo de acompanhamento, que pode variar de acordo com a natureza e as características da população de interesse e/ou a intervenção, doença ou exposição. Para estimar uma duração apropriada de acompanhamento, os avaliadores devem ler vários artigos e definir o intervalo de duração do acompanhamento que será considerado adequado. As opiniões de especialistas em prática clínica ou pesquisa clínica também podem ajudar a determinar uma duração apropriada do acompanhamento. Por exemplo, se o objetivo for analisar o efeito de determinado fator ambiental em gestantes, o acompanhamento deve ser por nove meses.

- O acompanhamento foi completo e, em caso negativo, os motivos para perder o acompanhamento foram descritos e explorados?

Critérios para receber resposta “Sim”: se uma proporção alta de participantes recrutados finalizou o estudo (no mínimo, 80% dos participantes, em linhas gerais). Enquanto uma taxa de abandono (perda) de 5% ou menos é considerada insignificante, uma taxa de 20% ou mais pode impactar significativamente a validade do estudo. No entanto, em estudos de coorte conduzidos por longos períodos, uma taxa de abandono mais alta é esperada. Ademais, o relato dos esforços para acompanhar os participantes que desistiram pode ser considerado indicador de um estudo bem conduzido. Os avaliadores devem procurar uma descrição clara e justificável do motivo pelo qual as pessoas foram deixadas de fora, excluídas ou abandonaram o estudo.

- Foram utilizadas estratégias para lidar com o acompanhamento incompleto?

Critérios para receber resposta “Sim”: se os dados dos participantes perdidos no estudo foram considerados na análise. Alguns participantes podem ter sido retirados do estudo de coorte devido à mudança de emprego, outros por morte; no entanto, é importante que seus resultados sejam avaliados. Sendo assim, a análise dos participantes com períodos de acompanhamento desiguais terá que ser ajustada no estudo, de forma a permitir diferenças na duração dos períodos de acompanhamento. O viés de seleção pode ocorrer como resultado de acompanhamento incompleto.

- Foi usada uma análise estatística apropriada?

Critérios para receber resposta “Sim”: se a seção “Métodos” do estudo suficientemente detalhada para os avaliadores identificarem quais técnicas analíticas foram usadas (em particular, regressão ou estratificação) e como fatores de confusão específicos foram medidos. Em estudos que utilizaram análise de regressão, cabe verificar se o estudo identificou quais variáveis foram incluídas e como se relacionam com o desfecho. Já, se a estratificação foi a abordagem analítica usada, identificar se os estratos de análise foram definidos pelas variáveis especificadas.

Quadro 2. Ferramenta de avaliação crítica de estudos de coorte desenvolvida pelo grupo de estudos do Joanna Briggs Institute (JBI) (em inglês)

| Reviewer_____________________________________________ Date ____________________

Author __________________________________ Year_________ Record Number___________

Overall appraisal: Include □ Exclude □ Seek further info □ |

Fonte: adaptado de Moola et al.1

2.2. Análise da qualidade metodológica em estudos caso-controle1

A ferramenta é composta por dez perguntas, as quais serão apresentadas a seguir, em tradução livre para a língua portuguesa, com orientações para análise. Ao final, é apresentado um quadro com as perguntas originais, em inglês (Quadro 3).

- Os grupos eram comparáveis, exceto pela presença de doença nos casos ou ausência de doença nos controles?

Critérios para receber resposta “Sim”: se a amostra foi por meio de pareamento individual, ou seja, quando os controles são selecionados para cada caso com base na similaridade em relação a certas características (idade, sexo etc.), que não a exposição de interesse. Sendo que viés de seleção pode ocorrer se os grupos não forem comparáveis. O grupo controle deve ser representativo da população que produziu os casos.

- Os casos e controles foram combinados de forma adequada?

Critérios para receber resposta “Sim”: se a fonte da amostra foi a mesma em ambos os grupos. Enquanto a anterior se refere às características das pessoas de cada grupo, esta requer avaliação da fonte da amostra. Os participantes do estudo podem ser selecionados da população-alvo, da população de origem ou de um grupo de participantes elegíveis (como em estudos caso-controle baseados em hospitais). Esta pergunta complementa a anterior.

- Os mesmos critérios foram usados para identificação de casos e controles?

Critérios para receber resposta “Sim”: se casos foram diagnosticados e/ou definidos claramente. Também é importante que os controles atendam a todos os critérios de elegibilidade (características populacionais) definidos para os casos, exceto aqueles relacionados ao diagnóstico da doença.

- A exposição foi medida de forma padrão, válida e confiável?

Critérios para receber resposta “Sim”: se o estudo descreveu claramente como a exposição foi medida. Considera-se medição padronizada quando todos os participantes foram avaliados da mesma forma (quando houver mais de uma exposição, considerar a principal para responder à pergunta). A validade da verificação da exposição está relacionada à adequação dos instrumentos ou métodos utilizados, se foram desenvolvidos para o estudo em avaliação ou se haveria outras formas validadas descritas na literatura (existência de um padrão de referência, por exemplo). Já a confiabilidade, refere-se à descrição de métodos adotados para assegurar reprodutibilidade da medida da exposição (confiabilidade intra e interobservador).

- A exposição foi medida da mesma forma para casos e controles?

Critérios para receber resposta “Sim”: se ambos os grupos (caso e controle) foram medidos e diagnosticados da mesma forma, sem influências externas.

- Foram identificados fatores de confusão?

Critérios para receber resposta “Sim”: se os autores do estudo identificaram e mensuraram os fatores de confusão em potencial. Um fator de confusão é uma diferença entre os grupos de comparação que influencia a direção dos resultados do estudo. Há fatores de confusão quando o efeito estimado da amostra, após a exposição, é enviesado pela presença de alguma diferença entre os grupos de comparação (além da exposição investigada/de interesse). Fatores de confusão típicos incluem características iniciais (no baseline), fatores prognósticos ou exposições concomitantes (por exemplo, tabagismo).

- Foram estabelecidas estratégias para lidar com fatores de confusão?

Critérios para receber resposta “Sim”: se os efeitos dos fatores de confusão foram ajustados por meio da combinação ou estratificação da amostragem dos participantes. Ao lidar com o ajuste na análise de dados, o método estatístico utilizado no estudo deve ser avaliado. Usualmente, compreende alguma forma de análise de regressão multivariada para explicar os fatores de confusão considerados.

- Os desfechos foram avaliados de forma padronizada, válida e confiável para casos e controles?

Critérios para receber resposta “Sim”: se o estudo descreveu claramente como o desfecho foi medido. Esta pergunta possui a mesma explicação da pergunta número 4, contudo, direcionada ao desfecho. A validade da verificação do desfecho está relacionada à adequação dos instrumentos ou métodos utilizados, se foram desenvolvidos para o estudo ou se haveria outras formas validadas descritas na literatura (existência de um padrão de referência, por exemplo). Já a confiabilidade, refere-se à descrição de métodos adotados para assegurar reprodutibilidade da medida do desfecho (confiabilidade intra e interobservador).

- O período de exposição de interesse foi longo o suficiente para ser significativo?

Critérios para receber resposta “Sim”: se o tempo de exposição foi longo o suficiente para mostrar uma associação entre a exposição e o desfecho. Por outro lado, é possível que o período de exposição tenha sido muito curto ou muito longo para influenciar o desfecho. Sendo que esse período deve ser acordado entre os avaliadores antes da avaliação metodológica.

- Foi usada uma análise estatística apropriada?

Critérios para receber resposta “Sim”: se a seção “Métodos” do estudo foi suficientemente detalhada para os avaliadores identificarem quais técnicas analíticas foram usadas (em particular, regressão ou estratificação) e como os fatores de confusão específicos foram medidos. Em estudos que utilizaram análise de regressão, cabe verificar se o estudo identificou quais variáveis foram incluídas e como elas se relacionam com o desfecho. Já, se a estratificação foi a abordagem analítica usada, verificar se os estratos de análise foram definidos pelas variáveis especificadas.

Quadro 3. Ferramenta de avaliação crítica de estudos caso-controle desenvolvida pelo grupo de estudos do Joanna Briggs Institute (JBI) (em inglês)

| Reviewer______________________________________________ Date ____________________

Author __________________________________ Year_________ Record Number___________

Overall appraisal: Include □ Exclude □ Seek further info □ |

Fonte: adaptado de Moola et al.1

2.3. Análise da qualidade metodológica em estudos transversais analíticos1

A ferramenta é composta por oito perguntas, apresentadas a seguir, em tradução livre para a língua portuguesa, com orientações para análise. Ao final, há um quadro com as perguntas originais, em inglês (Quadro 4).

- Os critérios de inclusão na amostra foram claramente definidos?

Critérios para receber resposta “Sim”: se os autores do estudo avaliado especificaram com detalhes quais foram os critérios de inclusão e exclusão dos participantes antes de recrutá-los para o estudo (por exemplo, estágio da doença, idade etc.)

- Os sujeitos do estudo e o ambiente foram descritos com detalhamento?

Critérios para receber resposta “Sim”: se a amostra do estudo foi descrita com detalhes (como foram selecionados os participantes, sexo, média de idade, informações demográficas, localização, período de tempo etc.), de forma que outros pesquisadores possam comparar a amostra em questão com a população de seu interesse.

- A exposição foi medida de forma válida e confiável?

Critérios para receber resposta “Sim”: se o estudo descreveu claramente como a exposição foi medida. A validade da verificação da exposição está relacionada à adequação dos instrumentos ou métodos utilizados, se foram desenvolvidos para o estudo em avaliação ou se haveria outras formas validadas descritas na literatura (existência de um padrão de referência, por exemplo). Já a confiabilidade, refere-se à descrição de métodos adotados para assegurar reprodutibilidade da medida da exposição (confiabilidade intra e interobservador).

- Foram usados critérios objetivos e padronizados para a medição da condição?

Critérios para receber resposta “Sim”: se o estudo descreveu que todos os pacientes incluídos no estudo foram submetidos ao mesmo método de diagnóstico ou definição específica da mesma maneira, independentemente de influências externas. Esta pergunta se refere ao viés de avaliação.

- Foram identificados fatores de confusão?

Critérios para receber resposta “Sim”: se os autores do estudo identificaram e mensuraram os fatores de confusão em potencial. Um fator de confusão é uma diferença entre os grupos de comparação que influencia a direção dos resultados do estudo. Há fatores de confusão quando o efeito estimado da amostra após a exposição é enviesado pela presença de alguma diferença entre os grupos de comparação (além da exposição investigada/de interesse). Fatores de confusão típicos incluem características iniciais (no baseline), fatores prognósticos ou exposições concomitantes (por exemplo, tabagismo).

- Foram estabelecidas estratégias para lidar com fatores de confusão?

Critérios para receber resposta “Sim”: se os efeitos dos fatores de confusão foram ajustados por meio da combinação ou estratificação da amostragem dos participantes. Ao lidar com o ajuste na análise de dados, o método estatístico utilizado no estudo deve ser avaliado. Usualmente, compreende alguma forma de análise de regressão multivariada para explicar os fatores de confusão considerados.

- Os resultados foram medidos de forma válida e confiável?

Critérios para receber resposta “Sim”: se o estudo descreveu claramente como o desfecho foi medido. Esta pergunta é semelhante à 3, porém, com enfoque em como os desfechos foram medidos/diagnosticados. A validade da verificação do desfecho está relacionada à adequação dos instrumentos ou métodos utilizados, se foram desenvolvidos para o estudo ou se haveria outras formas validadas descritas na literatura (existência de um padrão de referência, por exemplo). Já a confiabilidade, refere-se à descrição de métodos adotados para assegurar reprodutibilidade da medida do desfecho (confiabilidade intra e interobservador).

- Foi usada uma análise estatística apropriada?

Critérios para receber resposta “Sim”: se a seção “Métodos” do estudo foi suficientemente detalhada para os avaliadores identificarem quais técnicas analíticas foram usadas (em particular, regressão ou estratificação) e como fatores de confusão específicos foram medidos. Em estudos que utilizaram análise de regressão, cabe verificar se o estudo identificou quais variáveis foram incluídas e como se relacionam com o desfecho. Já, se a estratificação foi a abordagem analítica usada, verificar se os estratos de análise foram definidos pelas variáveis especificadas.

Quadro 4. Ferramenta de avaliação crítica de estudos transversais analíticos desenvolvida pelo grupo de estudos do Joanna Briggs Institute (JBI) (em inglês)

| Reviewer_____________________________________________ Date ____________________

Author __________________________________ Year_________ Record Number___________

Overall appraisal: Include □ Exclude □ Seek further info □ |

Fonte: adaptado de Moola et al..1

3. Interpretação

Os documentos disponíveis, com orientações para aplicação da ferramenta, não mencionam ponto de corte para a interpretação, contudo, informam que a equipe deve deixar os critérios explícitos e concordar entre si para determinar se um estudo é de qualidade “Boa”, “Moderada” ou “Baixa”. Além disso, os desenvolvedores enfatizam que a importância atribuída a cada critério dos checklists (por exemplo, viés de seleção, viés de aferição, viés de confusão) poderá variar de acordo com o desenho dos estudos incluídos e natureza da Revisão Sistemática em desenvolvimento1. Mas, de qualquer forma, as decisões sobre o sistema de pontuação e possíveis pontos de corte devem ser definidas e acordadas por todos os avaliadores participantes antes do início da análise crítica.2 Um exemplo de atribuição de pontos de corte está disponível na Tabela 1.

Ressalta-se que a metodologia adotada pelo JBI prevê a exclusão de estudos cujo julgamento geral (overall appraisal) foi de qualidade metodológica “Baixa”, conforme pode ser observado ao final das ferramentas apresentadas nos Quadros 2 a 4 deste capítulo (opções “Incluir”, “Excluir” ou “Procurar mais informações”). Contudo, usualmente, não se excluem estudos da Revisão Sistemática com base na qualidade metodológica, sendo essa etapa das ferramentas desconsiderada.

4. Apresentação dos resultados

A apresentação dos resultados da análise da qualidade metodológica com as ferramentas do JBI pode ser tanto em forma narrativa no texto quanto em tabelas, demonstrando cada aspecto da qualidade metodológica (cada item da ferramenta) para cada estudo individual e uma avaliação global do conjunto dos estudos incluídos. É importante fazer um resumo narrativo da qualidade metodológica dos estudos incluídos em relação a cada um dos critérios de avaliação crítica, com uma indicação clara das limitações metodológicas presentes. A tabela deve conter os estudos incluídos, o resultado da análise de cada item do checklist utilizado e a avaliação geral de cada estudo, podendo ser inserida no corpo da Revisão Sistemática ou disponibilizada na forma de material suplementar.2

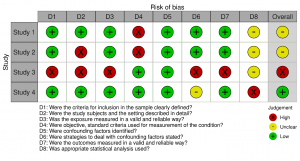

Além disso, os resultados podem ser apresentados por meio de gráficos de “semáforo” ou de “barras ponderadas”3 gerados com o software Review Manager4 ou com o software online robvis5, utilizando o template “Generic dataset”. Um passo a passo da geração das figuras pode ser encontrado no Capítulo 15 desse livro.

Exemplos de representação de resultados da análise da qualidade metodológica usando as ferramentas JBI são apresentados na Tabela 1 e na Figura 1A e B (Gráfico de “semáforo” e gráfico de “barras ponderadas”, respectivamente).

Tabela 1. Exemplo de apresentação tabular de resultados da avaliação crítica da qualidade metodológica dos estudos incluídos, usando a ferramenta para estudos transversais analíticos do JBI2

| Studies | Q1 | Q2 | Q3 | Q4 | Q5 | Q6 | Q7 | Q8 | Total | Quality |

| Study 1 |

Y |

Y | Y | N | Y | Y | Y | UN | 6 |

Moderate |

| Study 2 |

Y |

N | Y | N |

Y |

Y |

Y | UN | 5 |

Moderate |

| Study 3 |

N |

N | N | Y | Y | N | N | UN |

2 |

Low |

| Study 4 |

Y |

Y | Y | Y | Y | UN |

Y |

Y |

7 |

High |

Legend: Y= Yes; N= No; U= Unclear; NA= Not applicable; Q1. Were the criteria for inclusion in the sample clearly defined? Q2. Were the study subjects and the setting described in detail? Q3. Was the exposure measured in a valid and reliable way? Q4. Were objective, standard criteria used for measurement of the condition? Q5. Were confounding factors identified? Q6. Were strategies to deal with confounding factors stated? Q7. Were the outcomes measured in a valid and reliable way? Q8. Was appropriate statistical analysis used?

Nota: Neste exemplo a qualidade metodológica foi categorizada como “Baixa” quando o estudo obteve até três respostas “Sim” para os itens avaliados; “Moderada” quando o estudo obteve cinco ou seis respostas “Sim”; e “Alta” quando o estudo atingiu sete ou mais respostas “Sim”.

Fonte: elaborada pelos autores.

Figura 1. Exemplo de representação gráfica da avaliação da qualidade metodológica dos julgamentos dos autores para cada estudo incluído, a partir da avaliação da ferramenta para estudos transversais analíticos do JBI2. (A) Gráfico de “semáforo”, (B) gráfico de “barras ponderadas”

(A)

(B)

Nota: Os dados representados nos gráficos se referem aos dispostos na Tabela 1. O resultado da qualidade global para cada estudo (Overall) foi definido de acordo com os critérios descritos na nota da Tabela 1.

Fonte: elaborada pelos autores a partir da ferramenta online robvis.

Referências

- Moola S, Munn Z, Tufanaru C, Aromataris E, Sears K, Sfetcu R, et al. Systematic reviews of etiology and risk. In: Aromataris E, Munn Z, editors. JBI Manual for Evidence Synthesis [Internet]. Adelaide: JBI; 2020. [cited 2021 Aug 05]. Chapter 7. Available from: https://doi.org/10.46658/JBIMES-20-06

- Tufanaru C, Munn Z, Aromataris E, Campbell J, Hopp L. Systematic reviews of effectiveness. In: Aromataris E, Munn Z, editors. JBI Manual for Evidence Synthesis [Internet]. Adelaide: JBI; 2020. [cited 2021 Aug 05]. Chapter 3. Available from: https://doi.org/10.46658/JBIMES-20-06

- Massignan C, Bolan M, Mezzomo LA, Porporatti A, De Luca Canto. Coleta de dados e análise do risco de viés. In: De Luca Canto G. Revisões Sistemáticas da Literatura: Guia Prático. Editora Brazil Publishing, Brasil, 2020. p. 91-113.

- RevMan (Review Manager). Version 5.4 [Software]. The Cochrane Collaboration. 2020 [cited 2021 Aug 04]. Available from: https://training.cochrane.org/online-learning/core-software-cochrane-reviews/revman

- McGuinness, LA, Higgins, JPT. Risk-of-bias VISualization (robvis): An R package and Shiny web app for visualizing risk-of-bias assessments. Res Syn Meth [Internet]. 2021 Jan [cited 2021 Aug 04]; 1-7. Available from: https://doi.org/10.1002/jrsm.1411.